De la microélectronique au nanomonde : 35 ans de recherche en électronique à l'École Centrale de Lyon

Frédéric Gaffiot

Présentation des recherches menées à l'École Centrale de Lyon dans le domaine de la microélectronique, des enseignements dispensés dans l'établissement, au travers l'histoire de la discipline et de l'émergence des nanotechnologies.

Mots-clés :

Biopuces, Biotechnologie, Circuits intégrés, Filtres à ADN, Laboratoire Institut des Nanotechnologies de Lyon (INL), Loi de Moore, Microélectronique, Microtechniques, Nanotechnologie, Photonique, Silicium, Transistors.Keywords :

Biochips, Biotechnology, DNA microarrays, Integrated circuits, Laboratory Lyon Institute of Nanotechnology (INL), Microelectronics, Microtechnology, Moore's law, Nanotechnology, Photonics, Silicon, Transistors.Géographique :

Écully (Campus ECL),

Texte intégral

Texte intégral

Introduction

1 La courte histoire de la microélectronique est marquée par deux grandes tendances qui permettent d'appréhender les enjeux scientifiques et technologiques qui ont jalonné les dernières décennies et qui éclairent les évolutions probables dont les prémisses sont inscrites dans les préoccupations les plus actuelles des laboratoires consacrés à cette discipline.

2Ces deux tendances concernent la complexité et l'hétérogénéité toujours croissantes des systèmes électroniques.

3Dans un premier paragraphe, je m'attacherai à préciser les enjeux scientifiques et rappellerai quelques dates fondatrices de la discipline. J'essaierai ensuite d'inscrire l'histoire locale du laboratoire de l'École Centrale de Lyon1 dans cette grande histoire mondiale, puis je donnerai un aperçu des conséquences de l'avancée des connaissances et des techniques sur le contenu des enseignements dispensés à l'ECL2. Enfin, à la lumière de son histoire, je m'attacherai à montrer que le laboratoire est déjà inscrit dans les évolutions vers le nanomonde.

- 1 Le laboratoire d'électronique (...)

- 2 École Centrale de Lyon

Les tendances historiques : complexité et hétérogénéité

4La première réalisation pratique d'un transistor date de 1947, le premier circuit intégré3 de 1959. Certes, ce dernier comprenait six transistors, mais il est bien l'ancêtre des puces qui rythment, surveillent, contrôlent le moindre de nos objets.

- 3 Un circuit intégré est (...)

5Bien sûr, depuis, le microprocesseur a été inventé (1971) ; bien sûr, les premiers ordinateurs personnels sont apparus (1977) mais, les principes fondamentaux étaient déjà là : la réalisation monolithique et collective de fonctions électroniques complexes par l'association de composants élémentaires.

6Ce sont ces principes qui ont permis de concevoir et de fabriquer des systèmes aux fonctionnalités toujours plus complexes et variées à des coûts unitaires toujours plus réduits, et qui expliquent l'extraordinaire fluidité4 de la microélectronique. Aujourd'hui, la microélectronique est le premier secteur industriel mondial et les moteurs de sa croissance se partagent entre des secteurs aux liens très étroits avec elle (informatique, télécommunications) et des secteurs pour lesquels elle contribue à améliorer la fonctionnalité des produits (automobiles, produits grand-public).

- 4 La fluidité d'une technologie (...)

7Son succès, la microélectronique le doit pour une bonne part aux propriétés remarquables du silicium, et pendant quarante ans, jusqu'au tournant du siècle environ, l'effort de recherche et développement des fondeurs visait essentiellement à l'amélioration des performances des circuits intégrés par des réductions successives du facteur d'échelle géométrique des transistors. Précisons que si, aujourd'hui, 95 % du marché mondial de la microélectronique est constitué de circuits sur silicium, la microélectronique utilise d'autres matériaux. Parmi eux, on trouve des matériaux alliés dits III-V5 aux propriétés optoélectroniques et aux performances fréquentielles inégalables. L'étude de ces matériaux et des composants associés, utilisés dans les domaines des télécommunications optiques et des circuits radiofréquences, a été le centre de gravité des recherches menées au Leom.

- 5 Les matériaux III-V sont des (...)

8Au tournant du siècle, la microélectronique entrait dans une nouvelle ère faite de complexité et d'hétérogénéité.

9Jamais avares de symboles sémantiques, nos collègues américains introduisirent les termes de nanoscale era ou de gigascale era, ce qui n'est contradictoire qu'en apparence : la taille caractéristique des transistors élémentaires atteignait 120 nanomètres alors que le nombre de transistors dans un circuit intégré approchait de 1 milliard. A ces échelles, d'une part, la physique résiste et les changements technologiques exigent de nouveaux concepts et, d'autre part, les méthodes de conception traditionnelles deviennent inefficaces.

10Par ailleurs, des efforts soutenus ont permis durant les années 90, d'adapter de nombreuses technologies de fabrication de capteurs et d'actionneurs et de les rendre compatibles avec les procédés de fabrication de circuits intégrés. Il devenait ainsi envisageable d'intégrer sur une puce de silicium, non seulement des circuits électroniques de traitement de l'information, mais aussi, des composants ayant des fonctions optiques, radiofréquences, mécaniques, biologiques... Le concept de système sur puce émergeait, autorisant à nouveau la conquête de nouvelles applications.

11Ayant construit une stratégie scientifique à spectre large, couvrant les champs disciplinaires de la science des surfaces et des matériaux, de la physique des composants à semi-conducteur, de l'optique, des sciences des systèmes intégrés, le Leom s'est donné les moyens de répondre aux défis qu'imposent la complexité et l'hétérogénéité des systèmes électroniques.

Toujours plus vite, toujours plus nombreux

12La croissance exponentielle de la complexité des circuits intégrés depuis plus de quatre décennies maintenant est sans doute le caractère historique le plus facilement observable du développement des technologies de la microélectronique. Il est habituel de mesurer cette augmentation de complexité à l'aune de celle des microprocesseurs (ce sont les circuits intégrés à la fonctionnalité la plus forte et sans doute aussi les plus symboliques de l'ubiquité de la microélectronique) ; il est alors possible de constater, qu'année après année, la fonctionnalité des microprocesseurs (caractérisée par le nombre de transistors intégrés pour les constituer) et leur fréquence de fonctionnement augmentent exponentiellement de telle sorte que leur performance globale double environ tous les ans, qui plus est, avec un prix unitaire approximativement constant.

13Comment est-ce possible ?

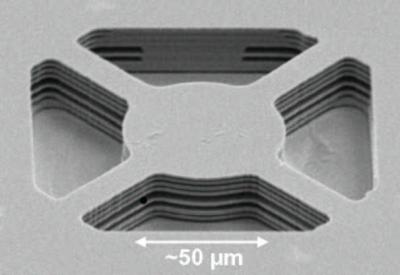

14Un circuit intégré est constitué de transistors (jusqu'à plusieurs centaines de millions pour les microprocesseurs les plus récents). Un transistor, au moins pour les circuits numériques, peut être vu comme un interrupteur contrôlable : l'électrode de commande permet de faire passer le transistor d'un état ouvert à un état fermé (G, figure 1).

Figure 1 : structure schématique d'un transistor MOS. Le courant I est contrôlé par la tension imposée sur la grille isolée (G) . La longueur du canal, L, régit, pour une bonne part, le comportement du transistor. Le motif minimal (de taille λ) caractérise une technologie

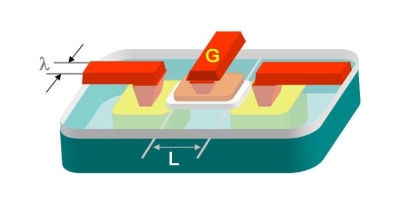

Un circuit élémentaire (une porte) de traitement numérique d'une information binaire est constitué d'un petit nombre de transistors interconnectés qui réalise une fonction logique particulière (figure 2).

Figure 2 : exemple de porte élémentaire Il s'agit d'une porte NAND, constituée de 4 transistors, qui effectue l'opération logique élémentaire

15 On comprend que plus le nombre de transistors disponibles sur un circuit intégré est élevé, plus le nombre de portes élémentaires et plus la fonctionnalité globale du circuit complet sont eux-mêmes élevés : l'augmentation de la fonctionnalité des circuits passe par l'augmentation de leur complexité.

16Pour des raisons évidentes d'encombrement (mais aussi pour des raisons plus cachées de rendement de production), l'augmentation du nombre de transistors sur un circuit impose que leur taille individuelle diminue : c'est donc la réduction de la taille (géométrique) des transistors qui a rendu possible l'augmentation de la fonctionnalité des circuits intégrés.

17Mais, ce n'est pas tout. Les lois physiques qui régissent le comportement des transistors montrent que, plus leur taille est réduite, plus ils peuvent travailler vite (plus la fréquence avec laquelle on peut rythmer le traitement de l'information est élevée).

18Ainsi, pour reprendre une expression consacrée : dans le monde électronique, small is better : plus la taille individuelle des transistors élémentaires est réduite, plus les circuits qu'ils construisent sont complexes et rapides.

19Cette évolution, à l'œuvre depuis plus de quarante ans, visant à réduire la taille des transistors pour améliorer les performances des circuits intégrés est couramment décrite par la loi empirique énoncée pour la première fois par Gordon Moore en 19656 : dans son énoncé initial, la loi de Moore met en évidence que la complexité pour les circuits à coût unitaire minimal a augmenté environ d'un facteur 2 par an (de 1959 à 1965) et prévoit que il n'y a pas de raison de croire que ce facteur ne restera pas approximativement le même pour au moins 10 ans.

- 6 Cramming more components onto (...)

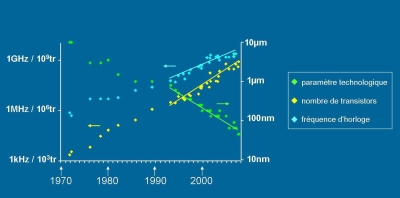

20La loi de Moore est résumée sur la figure 3 : à chaque génération, la taille des motifs minimaux tracés sur un circuit intégré diminue, corrélativement, la complexité des circuits ainsi que leur vitesse de fonctionnement augmentent.

Pour des microprocesseurs de plusieurs familles, on a reporté le nombre de transistors du circuit, la fréquence d'horloge et le paramètre de la technologie (l), à la date d'introduction sur le marché.

Pour la période 1993-2007, le nombre de transistors est multiplié par 1,5 par an et la fréquence d'horloge par 1,3. Le paramètre technologique est divisé par 2 en 2 ans.

21Les conséquences de la loi de Moore sont multiples et nécessiteraient des développements qui dépassent le cadre de ce court texte7, on conçoit néanmoins que la plupart des étapes technologiques nécessaires à la fabrication des systèmes intégrés doivent connaître des changements qualitatifs et quantitatifs incessants pour que l'amélioration des performances se poursuive.

- 7 Le premier chapitre de la (...)

22L'entrée dans l'ère nanométrique a marqué une rupture : la seule adaptation des technologies antérieures ne permettra pas de poursuivre le rythme des améliorations de performance. Devant ce constat, dès la fin des années 90, les principaux fondeurs américains prirent l'initiative de publier une feuille de route qui traduit un objectif global de performance et de coût des systèmes électroniques, fondé sur le prolongement de la loi de Moore dans les années futures, en termes de spécifications à atteindre pour les technologies, matériaux, composants, méthodes et équipements nécessaires à la fabrication des systèmes intégrés.

23Depuis 2000, la feuille de route est devenue internationale, elle est publiée tous les deux ans sous l'égide de l'association internationale des industries des semi-conducteurs.

24A titre d'illustration, évoquons l'épineux problème des interconnexions métalliques entre les composants d'un système intégré.

25La taille des transistors diminue, génération après génération. Les pistes métalliques qui interconnectent ces composants doivent donc être toujours plus denses et leur section toujours plus réduite, donnant naissance à des structures spectaculaires (figure 4).

Figure 4 : photographie (crédits photo : www.ibm.com) des couches d'interconnexion d'un circuit intégré. Dans cette technologie, 7 couches de métallisation (du cuivre) permettent de réaliser les interconnexions entre les transistors

26La réduction des tailles des interconnexions conduit à l'augmentation du temps de propagation des signaux électriques sur ces pistes et, donc, au paradoxe suivant : à chaque nouvelle génération technologique, les composants actifs (les transistors) sont plus rapides (et, en conséquence, le traitement de l'information potentiellement plus efficace) mais la propagation des signaux entre eux est plus lente, au risque de « ralentir » le fonctionnement global du système.

27Devant cet état de fait, il est donc nécessaire, pour respecter les exigences globales de la feuille de route, de mettre en œuvre des solutions évolutives (nouveaux matériaux diélectriques visant à réduire le temps de propagation, méthodes de conception ou architectures originales visant à réduire la longueur moyenne des interconnexions...) ou révolutionnaires (architectures asynchrones permettant de s'affranchir des contraintes temporelles dues à la propagation, nouveaux concepts de propagation des signaux à l'échelle d'une puce fondés sur l'optique ou sur les ondes radiofréquences). Il va sans dire que la feuille de route est un moteur extrêmement puissant qui induit des efforts de recherche dans des champs de disciplines extraordinairement divers.

Toujours plus hétérogène

28Très tôt après l'invention des circuits intégrés, de nombreuses applications ont visé le monde des télécommunications. Mais c'est bien sûr l'avènement de la téléphonie mobile et des réseaux dans les années 80 qui a consacré la convergence entre le monde des télécommunications et celui de la microélectronique.

29L'apparition des réseaux à haut débit fondés sur l'utilisation de l'optique (lasers à semi-conducteur et fibres optiques) puis des télécommunications mobiles ont impulsé des efforts de recherche et de développement considérables pour la mise au point de composants et de circuits électroniques fonctionnant à des fréquences supérieures au gigahertz. L'histoire se poursuit avec l'émergence de systèmes de transmission "tout optique" dans lesquels l'information ne sera pas seulement transportée mais aussi traitée sous forme optique.

30D'autres convergences technologiques sont apparues ces vingt dernières années, moins médiatiques, elles n'en ont pas moins modifié considérablement de nombreux champs de l'ingénierie et provoqué l'émergence de nouvelles thématiques scientifiques et de nouveaux développements technologiques.

31Ainsi, l'apparition du concept de microsystème, au début des années 90, a conduit à réaliser des systèmes intégrés ayant des fonctionnalités non seulement électroniques mais aussi optiques et mécaniques, grâce aux propriétés intrinsèques tout à fait remarquables du silicium et à des avancées spectaculaires des technologies de fabrication issues des procédés de la microélectronique.

32A l'heure actuelle, la convergence technologique la plus prometteuse concerne sans aucun doute la santé. En effet, après l'apparition des puces à adn, l'émergence des labs-on-chip et des puces à protéome permette de développer de nouvelles méthodes diagnostiques et même de nouveaux protocoles thérapeutiques.

33Ainsi, d'une part, l'hétérogénéité des systèmes sur puce est à la source de nombreux champs de recherche visant à rendre compatibles des technologies mais aussi des outils et méthodes de conception et de fabrication (qu'on imagine, par exemple les efforts à mettre en œuvre pour que les outils de conception développés dans des communautés scientifiques différentes et devenus très souvent des standards de fait, puissent communiquer ensemble, pour permettre la simulation de microsystèmes multi-physiques.)

34D'autre part, les champs d'application s'élargissent considérablement (il est, par exemple, possible d'imaginer équiper une nacelle de réacteur d'avion de microsystèmes électromécaniques qui rendent possibles des stratégies de contrôle actif du bruit ou de développer des réseaux de capteurs autonomes, communiquant par ondes radio, permettant de surveiller et de contrôler un environnement), élargissant par là même le champ des recherches possibles.

35Ainsi, les évolutions historiques de la microélectronique est elle marquée par une marche soutenue vers la complexité et l'hétérogénéité des systèmes. L'histoire du laboratoire d'électronique de l'ecl est inscrite dans ces évolutions...

Une vision historique des recherches au laboratoire de l'ECL

36Le paragraphe précédent aura montré, je l'espère, qu'un laboratoire consacré à la microélectronique doit couvrir des champs disciplinaires très divers ; une stratégie a été mise en œuvre au laboratoire de l'École Centrale de Lyon, qui couvre des thématiques « du matériau au système ». De plus, très tôt comme on le verra, les chercheurs et les directeurs8 successifs du laboratoire ont acquis la conviction que cette stratégie ne peut être fructueuse sans la mise en œuvre de moyens d'élaboration et de caractérisation permettant avec souplesse et réactivité de valider grâce à des prototypes expérimentaux, les idées développées au laboratoire.

- 8 Le Laboratoire a été (...)

37A l'origine, le laboratoire était consacré essentiellement à l'automatique et au contrôle industriel. Puis, avec l'arrivée du professeur Urgell en provenance de Toulouse, le tournant de la microélectronique est pris.

38Si, aujourd'hui, dans l'industrie microélectronique, le matériau très largement dominant est le silicium et la technologie d'intégration le cmos 9, dans les années 70 et au début des années 80, de nombreuses solutions étaient encore envisagées pour la fabrication de circuits intégrés (des alliages semi conducteurs dits III-V tels que l'arséniure de gallium et le phosphure d'indium constituaient une alternative au silicium pour leurs performances en vitesse et la technologie bipolaire rapide mais gourmande en énergie était envisagée pour la réalisation des circuits). Cette époque était donc marquée par un foisonnement de recherches à la fois sur l'optimisation des processus technologiques et des composants eux-mêmes. On trouve là l'origine historique des thématiques qui sont encore présentes au sein du Leom : parmi les collègues10 qui ont constitué les premières équipes du laboratoire, certains se sont consacrés à l'optimisation des structures des composants élémentaires (essentiellement des composants bipolaires, bien que des travaux ait aussi été menés sur les transistors MOS), d'autres à l'optimisation de la croissance de matériaux semi-conducteurs III-V. Ces premiers travaux ont été rapidement reconnus par la communauté scientifique puisque le laboratoire a été associé au cnrs dès 1976.

39L'évolution ultérieure de la recherche publique dans le domaine de la microélectronique a été marquée par la volonté de l'État de rattraper le retard français dans le domaine des composants et des systèmes électroniques. Il était en effet devenu clair que l'avenir d'une politique autonome, en particulier en matière de télécommunications, passait par le développement d'une infrastructure industrielle permettant la production de composants et de circuits. L'État initia donc, en 1977, le plan « Circuits Intégrés »11 avec le souci de créer un cercle vertueux recherche de base, développement et prototypage, industrialisation.

- 11 Les bras armés de ce plan (...)

40Le Leame 12 fit rapidement partie des laboratoires universitaires reconnus comme performants et de premiers gros équipements financés par le cnrs furent installés — en particulier une salle blanche et un bâti d'épitaxie par jet moléculaire — au tout début des années 80, faisant du Leame un des laboratoires universitaires français les mieux pourvus en moyen d'élaboration et de caractérisation de matériaux et de composants. Les thèmes de recherche spécifiques concernaient les filières III-V (arséniure de gallium et phosphure d'indium) et visaient à optimiser le comportement de transistors ultra-rapides ; ces recherches sont à l'origine de travaux qui se sont affermis au cours des quinze dernières années et ont évolué vers l'étude de la croissance organisée de matériaux par épitaxie13. Les propriétés optiques et électriques des matériaux dépendent en effet très directement de leurs propriétés structurelles (l'agencement des atomes peut provoquer des contraintes mécaniques, voire des défauts cristallins ou des arrangements particuliers, qui ruinent ou exacerbent leurs propriétés optiques ou électriques) ; pour fabriquer des composants fonctionnels, il est donc impératif de maîtriser la structure des couches semi-conductrices à partir desquelles ils sont réalisés. Les retombées de ces recherches fondamentales concernent aujourd'hui les sources lasers à très faible courant de seuil, la réalisation de substrats universels permettant d'associer des matériaux semi-conducteurs différents, l'optimisation d'oxydes nécessaires à la poursuite de la feuille de route de la technologie CMOS.

41A la fin des années 70, la communauté scientifique et industrielle avait acquis la conviction que le silicium serait le matériau dominant pour la réalisation de circuits intégrés complexes, aussi, pour renforcer la recherche fondamentale dans ce domaine, le cnrs et le cea ont-ils crées en 1983 le gcis, Groupement Circuits Intégrés Silicium. Le gcis allait devenir un forum privilégié d'échanges entre chercheurs de diverses spécialités (technologies, composants élémentaires, systèmes complexes) et contribuer au financement, au Leame, d'étude sur des composants silicium (composants de puissance et structures MOS).

42Corrélativement à cette mobilisation scientifique, le ministère de l'éducation nationale prenait conscience de l'urgente nécessité de former des ingénieurs aux métiers de la microélectronique et lançait un plan de formation spécifique (1979). Le cnfm 14 était créé peu après avec pour objectif de coordonner l'effort de formation et de contribuer à développer des infrastructures pédagogiques et à équiper les établissements en moyens logiciels et matériels. Une première structure lyonnaise était créée en 1982, le Mil 15 avec l'ambition de fédérer les actions pédagogiques des trois établissements lyonnais. Au cours de ces discussions lyonnaises, il est revenu au Leame, fort de son expérience dans la simulation des composants de puissance, de développer des actions dans le domaine de la conception de systèmes intégrés. Cette première impulsion se prolongeait quelques années plus tard par la création d'un groupe de recherche sur la définition d'outils et de méthodes de conception de circuits intégrés (1988).

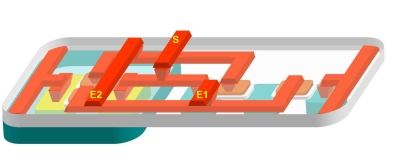

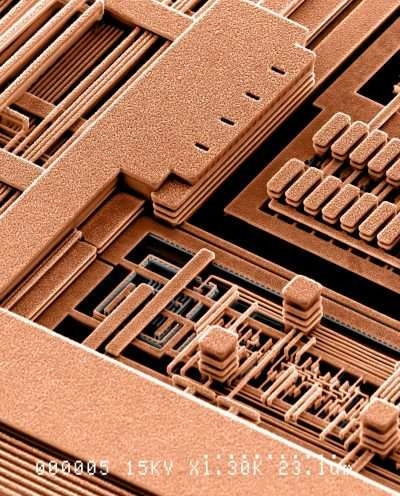

43L'évolution majeure suivante, dans l'histoire du Leom, est intervenue au milieu des années 90 avec son entrée dans le domaine de la microphotonique. Cette évolution s'est déroulée en plusieurs étapes. Le laboratoire ayant acquis des compétences de premier plan et disposant de moyens technologiques remarquables (en particulier, une salle blanche et des outils d'élaboration de matériaux semi-conducteurs III-V), un groupe, dirigé par Pierre Viktorovitch, a tout d'abord proposé et développé le concept de microsystèmes associant des propriétés mécaniques, électriques et optiques. Ces MOEMS trouvent des applications dans le domaine de la microanalyse et des télécommunications optiques : il est possible, en déplaçant sous l'effet d'un champ électrique, des microstructures mobiles (poutres et membranes micrométriques) de matériaux III-V de modifier le comportement optique de la microstructure et de réaliser ainsi des filtres optiques accordables ou des spectromètres miniaturisés (figure 5)

Figure 5 : structure MOEMS. Ce filtre accordable en longueur d'onde est constitué de couches de matériau semi-conducteur séparées par des lames d'air. Une actuation électrique permet de déplacer ces couches et donc de contrôler sa fonction de transfert optique

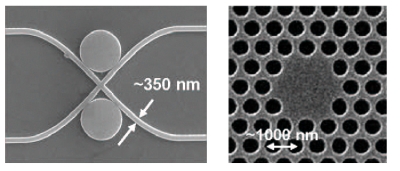

44Quelques années plus tard, les structures à bande photonique interdite ou cristaux photoniques ont polarisé l'attention de l'équipe « photonique ». Il s'agit de structures diélectriques ou semi- conductrices dans lesquelles l'indice de réfraction varie périodiquement ; elles affectent la propagation de la lumière lorsque la périodicité de la structure est du même ordre de grandeur que la longueur d'onde. La possibilité offerte par les technologies microélectroniques de structurer des matériaux à une échelle submicronique, a incité un intérêt renouvelé pour les structures à cristaux photoniques bi- et tridimensionnelles, à la fin des années 80. Au Leom, de telles structures (microcavités, structures guidantes ou réfractives,...) ont été réalisées sur des matériaux semi-conducteurs III-V, ce qui permet de profiter des propriétés optoélectroniques remarquables de ces matériaux et de leur indice de réfraction élevé. Ces structures, considérées comme des briques élémentaires, permettent d'imaginer de véritables circuits intégrés photoniques susceptibles de traiter une information sous forme optique comme un circuit intégré conventionnel traite l'information électrique (figure 6).

à gauche, des guides associés à des microdisques permettent de réaliser un filtre optique, à droite, un cristal photonique réalise une cavité résonnante

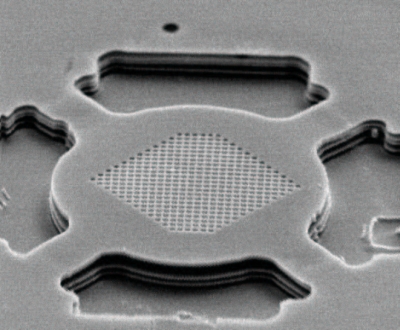

45De plus, l'association des concepts de MOEMS et de cristaux photoniques permet de réaliser des structures « actuables » dont les caractéristiques optiques peuvent être contrôlées avec une efficacité inégalée (figure 7).

46Enfin, un groupe a rejoint le Leom en 2003 et a permis la création de l'équipe « biotechnologies » dont les travaux, essentiellement interdisciplinaires, concernent le couplage des technologies issues de la microélectronique et de la biologie moléculaire, pour des applications en science du vivant : il s'agit de développer des biopuces et des microlaboratoires en associant des compétences en biologie, en chimie, en microfluidique avec les compétences historiques du laboratoire.

47Par exemple, le Leom dispose d'une plateforme biotechnologique ayant permis de fabriquer des puces à adn pour le diagnostic (mucoviscidose), le typage sanguin ou la détection d'agents pathogènes. Le savoir faire du laboratoire oriente les recherches vers les puces pour la protéomique qui faciliteront la compréhension des mécanismes d'interaction entre protéines, ou entre protéines et d'autres biomolécules.

48Comme on le voit, depuis maintenant plus de 30 ans, le laboratoire a développé une stratégie « du matériau au système ». Adossée à des moyens expérimentaux (élaboration et caractérisations de matériaux, technologie de fabrication de composants élémentaires et de circuits simples, caractérisations électriques et optiques, conception et simulation numérique) de tout premier ordre, cette stratégie a permis au laboratoire de faire croître sa visibilité nationale et internationale comme l'attestent sa production scientifique et la participation de ses chercheurs à de nombreux programmes de recherche nationaux ou européens.

Évolution de l'enseignement

49De façon naturelle, dans ses grandes lignes, l'enseignement dispensé à l'école dans les domaines de l'électronique et de la microélectronique a suivi les évolutions scientifiques et techniques décrites dans les paragraphes précédents, mais les adaptations ne se sont pas faites sans contraintes et ni sans contradictions et les débats furent parfois vifs au sein de notre équipe d'enseignants.

50En préalable, je tiens à évacuer d'emblée la question de la place à accorder à la microélectronique et aux disciplines associées dans la formation d'un ingénieur centralien ; trop souvent, en effet, cette place est remise en cause alors qu'au contraire, deux raisons objectives militent de manière incontestable, il me semble, en faveur de l'approfondissement de la formation dans ces disciplines.

51La première est relative à l'usage des systèmes électroniques intégrés dans d'autres champs disciplinaires : comme nous l'avons déjà souligné, l'électronique est une technologie extraordinairement fluide, qui contribue aux développements de tous les champs de l'ingénierie16. Ainsi, quel que soit le domaine dans lequel il exercera, un ingénieur sera confronté à des sous-systèmes microélectroniques de mesure, de traitement de l'information, de communication, de contrôle, de calcul scientifique... Cette tendance est générale : aucune rupture technologique récente ou prévisible dans les domaines de la santé, des transports, de l'énergie, des télécommunications, de la domotique, des loisirs..., n'est envisageable sans un apport accru de l'électronique. Il est ainsi exclu de faire preuve d'innovation (qu'elle concerne les produits ou les services) sans une connaissance suffisante de ce que rendent possible les technologies de la microélectronique.

- 16 Un seul exemple illustrera cet (...)

52La deuxième raison réside dans les développements propres des technologies microélectroniques : il est facilement concevable que, à mesure que les technologies progressent, des efforts accrus de recherche, de développement et d'industrialisation sont rendus nécessaires à la mise au point des outils et des méthodes permettant de poursuivre la feuille de route de l'itrs.

53Ainsi, un rapport parlementaire récent17 met en exergue la diffusivité et l'exigence de créativité de la microélectronique et fait état du déficit d'ingénieurs formés, en France, dans les disciplines associées.

- 17 Rapport sur l'évolution du (...)

54L'évolution de la microélectronique est, comme on l'a vu, marquée par une course vers la complexité et l'hétérogénéité des systèmes. Ce changement continuel provoque des évolutions des contenus de l'enseignement vers des concepts nouveaux susceptibles de rendre compte de l'augmentation continuelle de la fonctionnalité (en termes de performances et de diversité) des systèmes intégrés : on assiste alors, globalement, à un élargissement du spectre des compétences.

55D'une part, la tradition académique veut que l'enseignement d'une discipline commence par la construction d'un alphabet, c'est-à -dire l'élaboration des concepts élémentaires qui permettent d'appréhender théoriquement l'ensemble du champ disciplinaire18. Cette stratégie est efficace tant que la complexité des objets étudiés est faible (puisque leur comportement est principalement gouverné par celui des composants élémentaires qui le constituent) mais devient inopérante quand le système à appréhender comporte des milliers (voire des millions, puis des centaines de millions) de composants élémentaires, puisque son fonctionnement est régi bien plus par les interactions entre des sous-ensembles eux-mêmes complexes, que par le comportement des composants élémentaires.

- 18 Ainsi, traditionnellement, (...)

56Ainsi, jusque dans les années 80, au moment où la complexité des systèmes était faible cette vision traditionnelle était complètement opérante (la compréhension du comportement d'un transistor élémentaire permettait de comprendre le comportement du système complet), mais ensuite, il est devenu indispensable, pour appréhender le comportement global du système de mettre en oeuvre des outils et des méthodes permettant de gérer la complexité.

57Le temps étant compté, il est devenu impossible de tenir les deux bouts de la chaîne (d'un coté, un enseignement mettant l'accent sur la physique des composants élémentaires et de l'autre, un apprentissage des méthodes et outils de conception et d'analyse des systèmes complexes), les choix dans les programmes sont devenus incontournables, et bien sûr aussi les conflits entre physiciens et spécialistes des systèmes. Au mieux, cette contradiction a été résolue en séparant les enseignements relevant de la physique de ceux relevant des systèmes et en créant dans la formation des parcours spécifiques.

58D'autre part, la diversité des champs d'applications couverts aujourd'hui par les systèmes intégrés exige une diversification des compétences à acquérir. Ainsi, à coté des disciplines traditionnellement voisines (traitement du signal, propagation radiofréquence, automatique et informatique industrielle,...) il est de plus en plus nécessaire d'introduire dans les programmes des concepts19 nouveaux permettant d'appréhender les questions relatives à la conception, l'élaboration et l'utilisation des systèmes hétérogènes (physique de la basse dimensionnalité, micromécanique, microfluidique, chimie, optique, biologie...).

- 19 Il est d'ailleurs à noter que (...)

59En relisant les programmes des enseignements dispensés par les équipes d'enseignants du laboratoire, on constaterait donc un double mouvement au cours des années : une extension vers des niveaux plus élevés (extension qu'on dit parfois verticale, de la physique des composants de base aux outils de gestion de la complexité) et un accroissement du nombre de concepts de base abordés (extension horizontale qui permet de prendre en compte l'hétérogénéité des systèmes actuels).

Vers le nanomonde

60En guise de conclusion, je pense indispensable de tenter de décrire ce que seront, à court terme, les évolutions des recherches menées au laboratoire. Le changement de nom du laboratoire qui est devenu, en janvier 2007, l'Institut des Nanotechnologies de Lyon est une première expression de ces évolutions.

61Même si le mot « nanotechnologie » a été proposé au milieu des années 80, il est convenu de faire remonter l'histoire des nanotechnologies à une conférence prospective de 195920 dans laquelle le physicien Richard Feynman proclamait there is plenty of room at the bottom 21 et imaginait la possibilité de manipuler et contrôler des objets à une petite échelle.

62De nos jours, les nanotechnologies me semblent devoir être vues comme le résultat de la convergence de technologies issues de champs disciplinaires jusqu'alors presque indépendants (physique, chimie, microélectronique, biologie,...) et qui permettent de construire, d'assembler et de caractériser des structures et des objets de taille nanométrique.

63Deux voies sont possibles pour ce faire, la première, dite ascendante (bottom-up en anglais), consiste à assembler des composants élémentaires (atomes, molécules, agrégats) pour fabriquer des structures plus complexes et la seconde, dite descendante (ou top-down), utilise l'amélioration des procédés technologiques de la microélectronique qui permettent de réaliser des structures de taille inférieure à quelques dizaines de nanomètres.

64Ainsi, il devient possible de structurer la matière à une échelle où ses propriétés diffèrent fondamentalement de celles qu'on observe habituellement à l'échelle macroscopique ; les champs d'application de ces technologies apparaissent presque infinis et touchent tous les grands domaines de l'activité humaine22.

- 22 On trouvera sur le web de (...)

65Forts de l'expérience de leurs équipes, à la fois dans les technologies microélectroniques (voie descendante) et dans la physique de l'élaboration de structures auto-organisées (voie ascendante), forts aussi de la diversité des domaines d'application qu'elles étudient, les laboratoires lyonnais de l'École Centrale, de l'Institut National des Sciences Appliquées et de l'Université Claude Bernard ont choisi de conjuguer leur force au sein de l'Institut des Nanotechnologies de Lyon (inl) pour constituer un des principaux centres français de recherche en nanotechnologie. Le 31 mai 2007 a eu lieu la journée d'inauguration de l'inl, nul doute qu'elle marquera une nouvelle étape de la recherche en électronique à l'École Centrale de Lyon.

Notes

Notes

1 Le laboratoire d'électronique de l'école s'est appelé Leame (Laboratoire d'Électronique, d'Automatique et de Mesures Électriques) depuis sa création en 1970 jusqu'en 1999, puis Leom (Laboratoire d'Électronique, d'Optoélectronique et des Microsystèmes) jusqu'au 31 décembre 2006. A l'occasion, de la nouvelle contractualisation avec le cnrs (2007-2010), le Leom a fusionné avec ses sisterships de l'Insa (Institut National des Sciences Appliquées) et de l'Université Claude Bernard, pour former l'inl (Institut des Nanotechnologies de Lyon). Ces appellations successives sont symptomatiques de l'évolution des recherches menées au laboratoire, dans ce texte elles seront considérées comme synonymes

2 École Centrale de Lyon

3 Un circuit intégré est l'association monolithique, sur un substrat de matériau semi conducteur, de composants élémentaires réalisant une fonction électronique

4 La fluidité d'une technologie réside dans le fait que non seulement elle connaît ses propres développements techniques et scientifiques mais qu'elle permet des développements conséquents dans d'autres champs disciplinaires

5 Les matériaux III-V sont des alliages binaires, ternaires ou quaternaires d'éléments de la troisième et de la cinquième colonne du tableau de la classification périodique des éléments (Arsenic, Gallium, Indium, Aluminium, Phosphore)

6 Cramming more components onto integrated circuits, Electronics, Vol.38, n8, April 19, 1965

7 Le premier chapitre de la feuille de route donne un résumé des conséquences technologiques de la loi de Moore (www.itrs.net/reports.html), mais ses conséquences économiques sont également remarquables. Ainsi, une usine de fabrication de circuits intégrés (une fonderie) coûtait environ 100 millions d'euros en 1985, 700 millions en 1992 et plus de 3 milliards d'euros en 2005 !

8 Le Laboratoire a été successivement dirigé par le professeur J.J. Urgell de 1972 à 1980, Pierre Viktorovitch, directeur de recherche au cnrs, de 1981 à 1992 et Guy Hollinger, directeur de recherche au cnrs, depuis 1993

9 CMOS est l'acronyme de Complementary Metal Oxide Semiconductor. Dans une porte CMOS, l'utilisation de transistors complémentaires permet de réduire la consommation de puissance

10 Je souhaite citer, parmi les pionniers, Robert Blanchet, Olivier Bonnaud, Jean-Pierre Chante et Michel Garrigues

11 Les bras armés de ce plan furent le cea, et en particulier le Leti, le cnet et efcis, une petite société issue du cea et qui est l'embryon de stmicroelectronics

12 Une « cellule microélectronique » fut en particulier chargée de recenser les laboratoires universitaires les plus performants dans ces domaines. Il est assez regrettable que malgré l'existence, à cette époque, de forces et de compétences académiques remarquables, une émulation mal maîtrisée de ses laboratoires n'ait pas permis au site lyonnais de se maintenir parmi les tout premiers

13 Du grec ταξις arrangement et επι sur, par-dessus : procédé de croissance de matériaux qui respecte l'arrangement cristallin du substrat

14 Coordination Nationale pour la Formation en Microélectronique

15 Microélectronique Interuniversitaire Lyonnaise

16 Un seul exemple illustrera cet état de fait : une automobile actuelle de milieu de gamme compte plusieurs dizaines de processeurs qui en contrôlent et régulent tous les organes fonctionnels, l'électronique embarquée représente ainsi environ un quart du coût de la voiture

17 Rapport sur l'évolution du secteur des semi-conducteurs et ses liens avec les micro et nanotechnologies de l'Office parlementaire d'évaluation des choix scientifiques et technologiques (opecst no138) ; http://senat.fr/opecst/rapports.html

18 Ainsi, traditionnellement, l'enseignement de l'électronique commence-t-il par la description de la physique des matériaux semi-conducteurs ; s'ensuivent un cours de physique des composants élémentaires, puis un enseignement décrivant les fonctions élémentaires (numériques et analogiques) réalisées par l'association de quelques composants de base... Enfin, seulement, il est convenu qu'il devient possible de parler des concepts et des outils et méthodes relatifs aux systèmes complexes...

19 Il est d'ailleurs à noter que les phénomènes liés à la basse dimensionnalité des systèmes doivent être particulièrement soulignés

20 There's plenty of room at the bottom: an invitation to enter a new field of physics, Engineering and Science, Vol. 23:5, Fevrier 1960, California Institute of Technology

21 Littéralement : il y a beaucoup de place en bas

22 On trouvera sur le web de nombreux sites consacrés aux enjeux scientifiques, technologiques et sociétaux des nanotechnologies. Les sites http://www.nanomicro.recherche.gouv.fr, http://www.nanoforum.org, et http://www.nanotech-now.com, par exemple, constituent une bonne entrée en matière

Pour citer ce document

Pour citer ce document

Frédéric Gaffiot, «De la microélectronique au nanomonde : 35 ans de recherche en électronique à l'École Centrale de Lyon», Histoire de l'École Centrale de Lyon [En ligne], Mémoire de l'École Centrale de Lyon, Enseignement et Recherche en Sciences pour l'Ingénieur, mis à jour le : 01/12/2008, URL : http://156.18.19.153:443/index.php?id=641.